Odborná sekce

Jak na spolehlivé NAS služby?

17.10.2014, 15:13

Nějaký druh Network Attached Storage (NAS) dnes už potřebuje prakticky každý uživatel IT, ať se jedná o domácího uživatele, vědecké pracoviště nebo firmu jakékoli velikosti. A každý má právě teď problém s jeho kapacitou, samozřejmě relativní své důležitosti. A problém s kapacitou díky povaze zařízení NAS téměř vždy znamená i problém s výkonností. Obě tato slova, kapacita a výkon, jsou v IT žargonu pouze synonymy pojmu finanční náklady. Je tedy řešením NAS problému jedině pravidelné vypisování objednávky?

|

Vladimír Blažek je File & Content specialistou společnosti Hitachi Data Systems. Celý svůj profesionální život pracuje s řešeními pro ukládání dat všech velkých značek – HDS, IBM, EMC, HP, NetApp, Brocade, Quantum, Symantec, Commvault, Falconstor a dalšími.

|

V ČEM JE VLASTNĚ PROBLÉM?

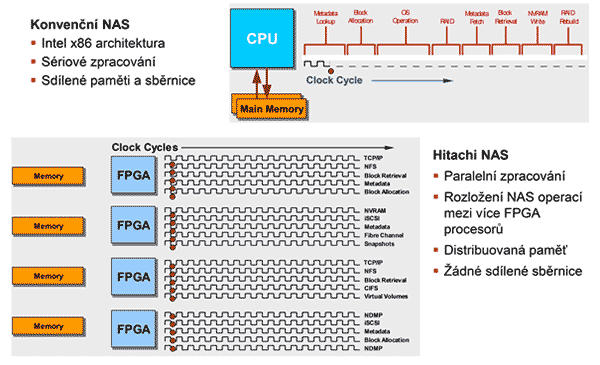

Většina existujících NAS řešení je postavena na komoditní INTEL x86 architektuře s podkladovým systémem většinou Linuxového typu. Z této architektury ale zároveň plynou i její omezení. Díky soustředění velké kapacity a velkého počtu uživatelů do sdíleného úložiště dochází k výkonnostním problémům. Sekvenční charakteristika přístupu z mnoha různých vláken se složí v random výslednici a obrovské množství operací s metadaty zatíží CPU.

METADATA

Metadaty v kontextu NAS se myslí strukturální metadata vypovídající o mapování datového objektu (souboru) na datové bloky a administrativní metadata určující práva k objektům/souborům – například strom inodů s administrativními metadaty například ACL. Vzhledem k povaze souborových protokolů NFS a CIFS je práce s metadaty kritická pro výkon NASu. Každý klient, který přistupuje na sdílený filesystém, si jak o první oper aci uděl á „l s“ nebo „di r“. Dal ší sk en adresářové struktury přijde při startu aplikace, při antivirovém skenu, přihlášení, odhlášení, zálohování, každé kontrole volného místa... Dalo by se říci, že v běžném provozu NAS nedělá prakticky nic jiného než „dir“.

UNIKÁTNÍ ŘEŠENÍ – HITACHI NAS: KDYŽ DVA DĚLAJÍ TOTÉŽ , NEMUSÍ TO BÝT TOTÉŽ

Hitachi NAS (HNAS) používá hardwarovou akceleraci NFS a CIFS operací. Operace s metadaty a přesun datových bloků mezi síťovým rozhraním NAS a blokovým rozhraním jeho disků jsou prováděny nikoli Intel CPU, ale paralelně soustavou čtyř FPGA (Field Programmable Gate Array), česky programovatelných hradlových polí. Motherboard CPU je pak k dispozici pro management a data management funkce. Použití FPGA zásadním způsobem zlepšuje schopnost paralelně zpracovávat operace. Výkon masivní sady 820 tisíc hradel násobně převyšuje výkon dosažitelný CISC instrukcemi Intel CPU. Každé FPGA má navíc integrováno až 24 transceiverů naprogramovatelných na 10GE a 8Gb FC, vlastní DDR3 paměťovou sběrnici a také PCI x8 interface. Implementace filesystému uvnitř sady FPGA se nazývá Hitachi Data Systems „SiliconFS“.

APLIKACE NA HNASU - DEDUPLIKACE

Nejzajímavější aplikací je deduplikace datových bloků. Deduplikace je speciální technika komprese dat, která zabraňuje ukládání stejných datových bloků na jednom úložišti. Jak už to na světě bývá, je vždy něco za něco a princip deduplikace je založen na počítání unikátních hash klíčů a to je výpočetně velmi náročný úkon. Jinak řečeno: daní za velmi významnou úsporu kapacity jsou požadavky na výkonnost hardware. Ostatní NASy zatěžují jediný druh procesoru, který mají k dispozici výpočtem hashů, vyhledáváním v hash indexu a porovnáváním nalezených datových bloků, které zamezí kolizím hashů. HNAS počítá silný hash SHA-256 z důvodu zabezpečení ochrany dat „jakoby mimochodem“, při průchodu datových bloků přes FPGA, ať jsou zrovna ukládány nebo čteny. Výpočet hash byl součástí firmware před implementací deduplikace, pouze se využilo to, co již existovalo.

|

Protože při použití 256bitového hashe nehrozí kolize, není potřeba provádět porovnání dat před deduplikací (kdo by přesto chtěl, může ho zapnout). Intel CPU se procesu deduplikace dat účastní pouze při vyhledávání hashe v indexu, což je svou povahou přesně taková činnost, na kterou bylo navrženo.

SNAPSHOTY A KLONY

Běžně požadovanou aplikací jsou snapshoty a klony. Při bližším zkoumání je jasné, že jsou to na metadata náročné operace. Pro zálohování, ochranu a testování například VM a Oracle instancí jsou ale klony a snapshoty nezbytné. Pro integraci s VMware ESX vCentrem nabízíme plug-in Virtual Infrastructure Integrator (V2I), který umožní ovládat a plánovat zálohování, obnovu a klonování VM přímo z prostředí administrace ESX a VM, přesně tak, jak jsou admini zvyklí. Zároveň jsou s ním provázány HDS pluginy VAAI a VASA, a také plugin pro Site Recovery Manager.

|

VYSOKÁ DOSTUPNOST

V případě požadavku na redundantní architekturu NAS (tak, aby výpadek jakékoliv komponenty nezpůsobil nedostupnost dat), lze Hitachi NAS clusterovat až na úroveň osmi nodového clusteru. Unikátní FPGA architektura také výrazně zlepšuje i tuto oblast. Rychlý failover při poruše, a konzistence dat při něm, je zaručen zrcadlením nonvolatile paměti pomocí dedikovaného 10Gb cluster interconnectu implementovaného také na FPGA, prováděného samostatnou skupinou hradel. Zrcadlení tudíž nemá vliv na výkon a NVRAM může být implementována jako write-back cache. Konzistence se týká nejen filesystému, ale také všech k němu přidružených snapshotů, klonů a replik.

TIEROVANÝ FILESYSTÉM

Další oblíbenou aplikací je tierovaný filesystém, tedy oddělení místa uložení metadat od místa uložení datových bloků. Strukturální metadata zpracovávaná FPGA se ukládají na SSD, což dále zrychluje skeny adresářů. Datové bloky mohou skončit na běžných rotujících discích a nejžádanější operace jsou provedeny rychlostí křemíku. Tuto funkci lze rozšířit i o tiering do důvěryhodného archivu HCP, do on-premise, privátního nebo i veřejného cloudu a také na LTO pásku s LTFS.

|

Naprostou novinkou je Universal Migrator, který umí na HNAS automaticky, transparentně a bez downtime odmigrovat existující NASy a fileservery. A to vše pěkně hardwarově. Tak, a pojďme se bavit o tom, jaké má kdo vychytané řešení a jak mu běhá :-)

Vladimír Blažek Senior Solutions Consultant, File & Content Solutions, Hitachi Data System